随着ChatGPT、文心一言等生成式人工智能的横空出世,人工智能大模型(Large Language Models, LLMs)已成为全球科技竞争的焦点。这类模型凭借海量参数和强大的涌现能力,在内容生成、代码编写、复杂推理等领域展现出前所未有的潜力,正深刻重塑人工智能应用软件的开发范式。机遇与风险并存,大模型的飞速发展也带来了一系列严峻的挑战,亟待开发者和监管者共同应对。

一、人工智能大模型发展带来的主要风险挑战

- 安全与伦理风险:

- 偏见与歧视:大模型从互联网海量数据中学习,可能固化甚至放大训练数据中存在的社会偏见、文化歧视,导致其生成的代码、内容或决策建议产生不公平的结果。

- 生成有害内容:模型可能被诱导生成虚假信息(深度伪造文本/图像)、仇恨言论、恶意代码或操作指南,对社会稳定、网络安全和个人权益构成威胁。

- 隐私与数据泄露:训练数据可能包含个人敏感信息,模型在推理时存在记忆并泄露这些信息的风险。用户与AI应用的交互数据也面临被滥用或泄露的隐患。

- 责任界定模糊:当AI应用基于大模型的输出做出错误决策并导致损害时(如医疗误诊、金融错误建议),责任主体是开发者、部署方还是模型提供方,目前法律上尚不清晰。

- 技术与性能风险:

- “幻觉”问题:大模型倾向于生成看似合理但事实上不正确或无依据的内容,这在需要高可靠性的应用(如法律咨询、学术研究)中尤为危险。

- 可解释性差:大模型的决策过程如同“黑箱”,开发者难以理解其内部逻辑,导致调试困难,也无法向用户解释特定输出的原因,影响信任。

- 资源消耗巨大:训练和部署大模型需要极高的算力、能源和资金成本,加剧了数字鸿沟,并将创新资源集中在少数大型科技公司手中。

- 依赖性风险:应用软件过度依赖单一或少数几个基础大模型,会带来供应链安全风险。一旦模型服务中断、接口变更或收费策略调整,大量应用将面临停摆。

- 社会与经济风险:

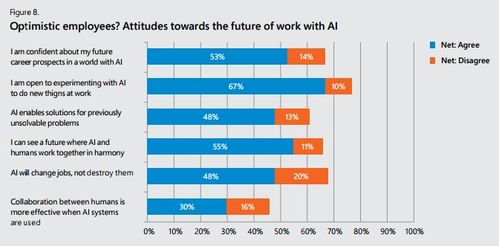

- 就业冲击:大模型驱动的自动化可能替代部分知识工作和创造性工作的初级任务,引发劳动力市场结构性调整和短期阵痛。

- 信息生态扭曲:低成本、大规模生成的内容可能泛滥,挤占高质量人类创作的空间,污染信息环境,扰乱舆论场。

- 垄断与集中:大模型的高门槛可能强化科技巨头的市场主导地位,抑制中小型创新企业的活力。

二、面向人工智能应用软件开发的应对策略

在应用软件开发层面,必须将风险管控融入设计、开发、部署和运营的全生命周期,构建负责任、可信赖的AI应用。

- 设计阶段:伦理先行与需求锚定

- 开展影响评估:在项目启动时,就应对应用可能带来的伦理、社会影响进行评估,明确其适用领域和限制边界。

- 精准定义需求:避免“为了用AI而用AI”。清晰定义软件要解决的具体问题,评估大模型是否是必要且合适的工具。优先考虑在风险可控的增强型场景(如辅助编程、内容创意启发、知识问答)中应用。

- 开发阶段:增强稳健与可控性

- 实施提示工程与微调:通过精心设计的提示词(Prompt)引导模型行为,结合特定领域的高质量数据对基础模型进行有监督微调(SFT),使其输出更符合专业要求和安全标准。

- 构建“护栏”与过滤系统:在模型输入输出端部署多层内容安全过滤器,实时检测和拦截有害、偏见或不合规的内容。采用宪法人工智能(Constitutional AI)等技术,让模型按照既定规则进行自我批判和修正。

- 开发可解释性工具:集成或开发可视化工具,尝试对模型的决策依据进行溯源和展示(如突出显示影响输出的关键输入部分),提升透明度。

- 采用检索增强生成(RAG):将大模型与外部知识库(如企业数据库、权威文献)相结合。让模型基于检索到的准确信息生成答案,而非仅依赖内部参数记忆,能有效缓解“幻觉”问题,并便于更新知识。

- 部署与运营阶段:持续监控与迭代

- 建立人机协同机制:关键决策点保留“人在环路”(Human-in-the-loop),由人类进行最终审核和判断。设计清晰的人机交互界面,明确标示AI生成内容。

- 实施持续监控与审计:对软件的实际运行效果进行持续监测,收集用户反馈,定期审计模型的输出是否存在新的偏差或风险。建立模型性能衰退的预警机制。

- 制定应急预案:为可能出现的模型故障、生成重大错误或安全事件制定详细的应急响应和处置流程。

- 保持技术多样性:避免单一模型依赖,探索集成多个不同架构或来源的基础模型,或结合传统规则引擎与小模型,以提高系统鲁棒性和灵活性。

- 组织与生态层面:构建治理体系

- 培养团队AI素养:开发团队需具备AI伦理、安全、合规知识,设立专门的AI安全官或伦理审查角色。

- 拥抱开源与协作:积极参与开源社区,利用经过安全审查的开源模型和工具,降低开发成本,共同推动安全标准建立。

- 推动行业标准与合规:主动了解和遵循国内外正在出台的AI法规与标准(如欧盟《AI法案》、中国的生成式AI服务管理办法),将合规要求内化到产品中。

###

人工智能大模型为应用软件开发开启了“智能增强”的新时代,但其带来的风险复杂且深远。成功的AI应用软件开发者,不仅是技术专家,更应是风险的管理者和价值的守护者。通过采取贯穿生命周期的系统性对策,将安全、可靠、公平、可控的原则深植于产品内核,我们才能驾驭这股智能浪潮,开发出真正造福社会、值得信赖的人工智能应用,推动技术向善而行。